Un mémo sur la mise en place d’un cluster en haute disponibilité d’hyperviseurs Proxmox avec un stockage distribuée et redondant Ceph. Cet article traite uniquement de la mise en cluster des noeuds Proxmox ainsi que l’installation et de la configuration de Ceph.

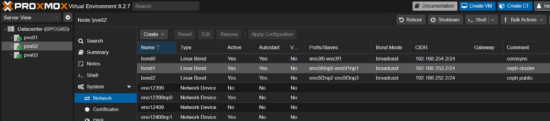

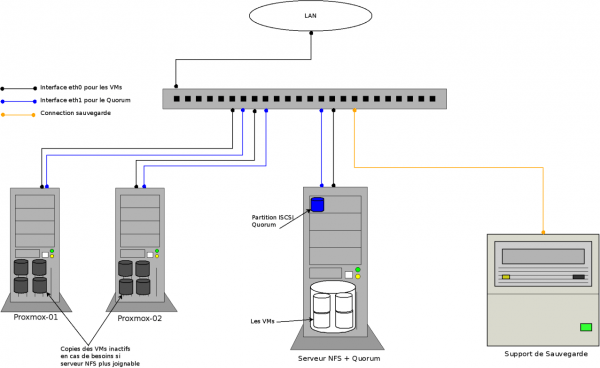

Configuration Réseau des noeuds Proxmox

Chaque réseau sera cablé en topologie MESH et les interfaces réseaux créés dans Proxmox seront des aggrégations en mode Broadcast.

Pour plus d’infos voir cet article : https://memo-linux.com/proxmox-creer-un-cluster-sur-un-reseau-prive-sans-switch/

- Adresse IP public des noeuds Proxmox :

- pve01 : 10.x.x.1

- pve01 : 10.x.x.2

- pve01 : 10.x.x.3

- Réseau Corosync (cluster Proxmox) : 192.168.254.0/24

- pve01 : 192.168.254.1

- pve02 : 192.168.254.2

- pve03 : 192.168.254.3

- Réseau Ceph :

- Ceph Public 192.168.252.0/24

- pve01 : 192.168.252.1

- pve02 : 192.168.252.2

- pve03 : 192.168.252.3

- Ceph Cluster 192.168.253.0/24

- pve01 : 192.168.253.1

- pve02 : 192.168.253.2

- pve03 : 192.168.253.3

- Ceph Public 192.168.252.0/24

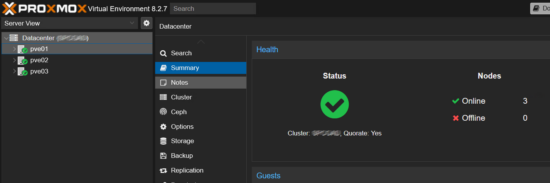

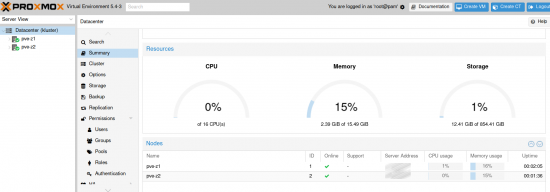

Mise en cluster des noeuds Proxmox

Avant la mise en cluster, il faut s’assurer absolument que chaque noeud soit à l’heure et synchronisé sur un serveur NTP.

chronyc tracking

- Initialisation du cluster sur un noeud aux choix :

pvecm create nom_cluster --link0 192.168.254.1

- Sur pve02 :

pvecm add 10.x.x.1 --link0 192.168.254.2

pvecm add 10.x.x.1 --link0 192.168.254.3

Installation de Ceph

L’installation et la configuration du Ceph sera réalisée via l’interface web de Proxmox.

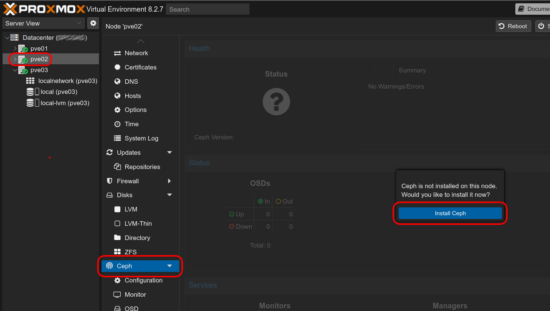

- Sélectionner un noeud, dans le menu cliquer sur Ceph puis cliquer sur « Install Ceph » :

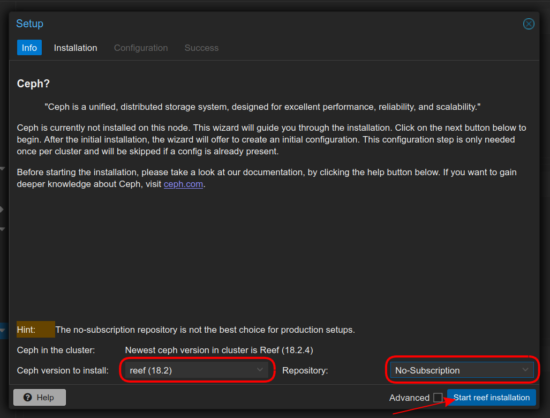

- Une nouvelle fenêtre s’ouvre, sélectionner la dernière version de Ceph (Reef) et le dépôt No-Subscription puis cliquer sur « Start reef installation » :

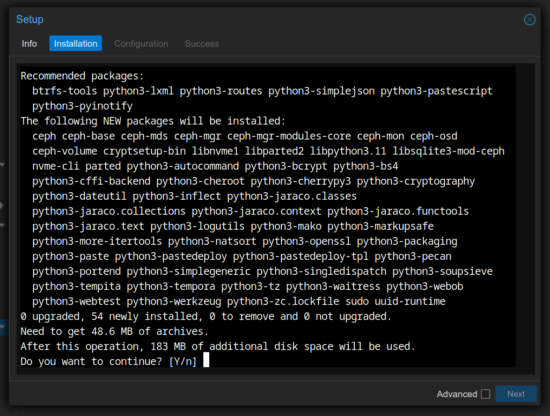

- Répondre « Y » puis la touche « Enter » du clavier :

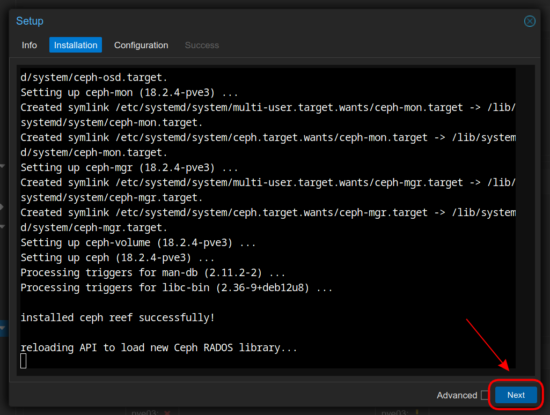

- Une fois l’installation terminée, cliquer sur « Next » :

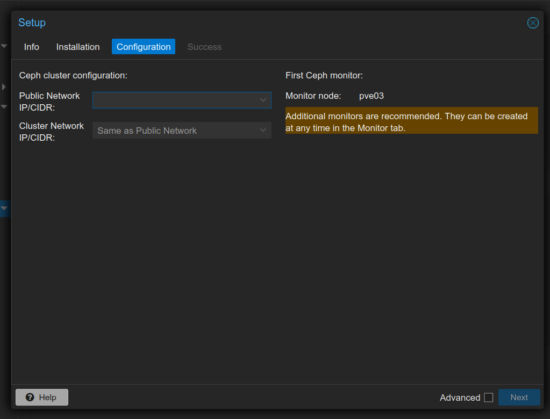

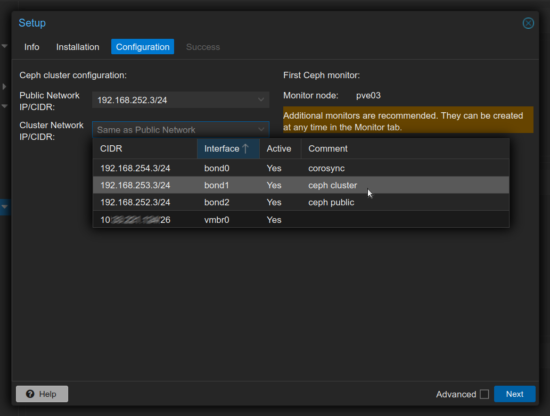

- Configuration réseau du cluster de Ceph :

- Sélectionner les adresses IP configurées pour chaque réseau Public et Cluster du Ceph :

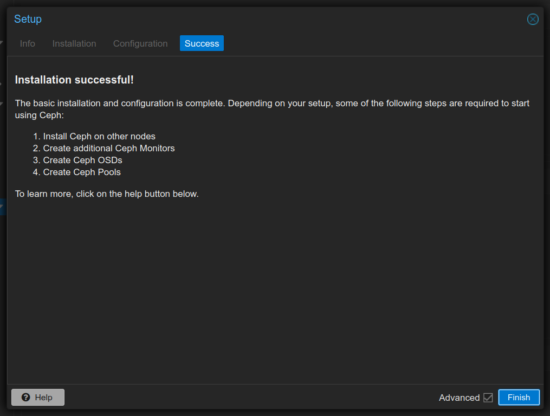

- Installation et configuration du Ceph terminée :

Cependant, il faut refaire l’étape d’installation du Ceph sur les autres noeuds (sans la partie réseau).

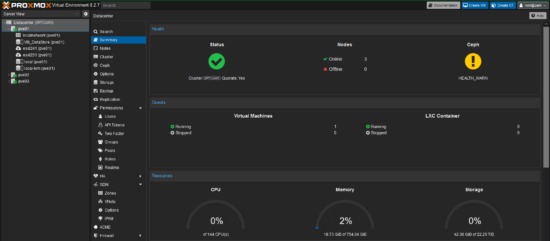

Mise en place du Ceph sur le cluster Proxmox

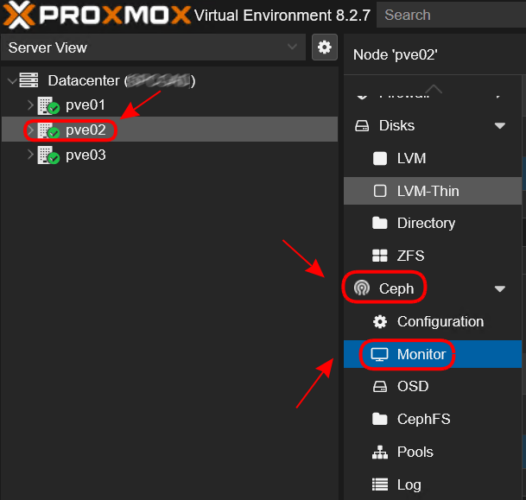

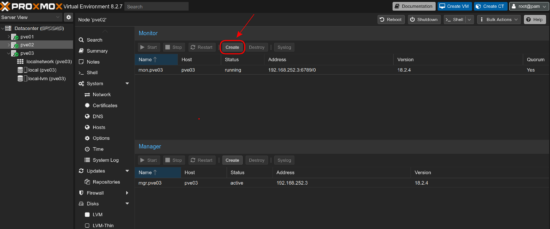

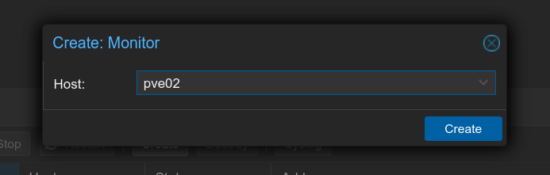

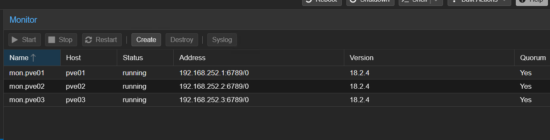

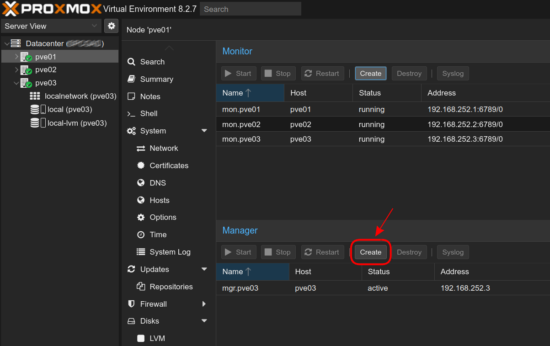

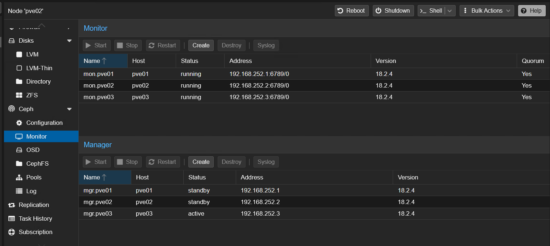

- Sur chaque noeud, créer le Ceph Monitors :

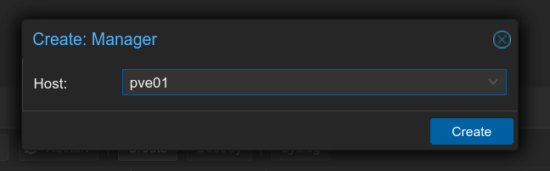

- Sur chaque noeud, créer le Ceph Manager :

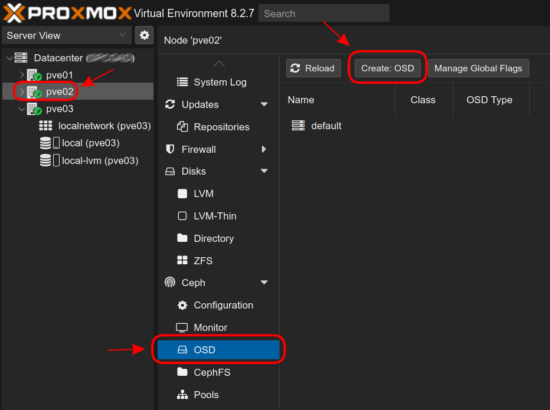

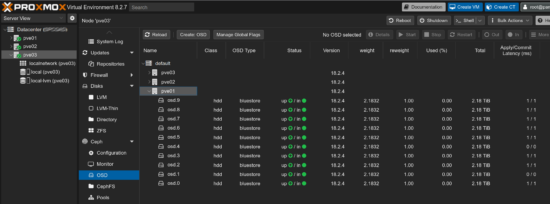

- Création des OSD :

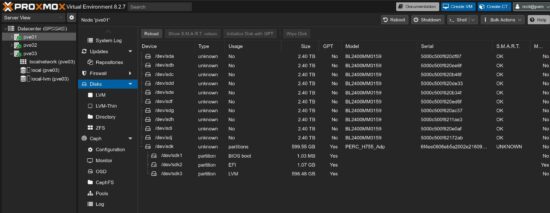

- Pré-requis, il faut que les disques soient configurés en NON-RAID et visible dans le menu « Disks » :

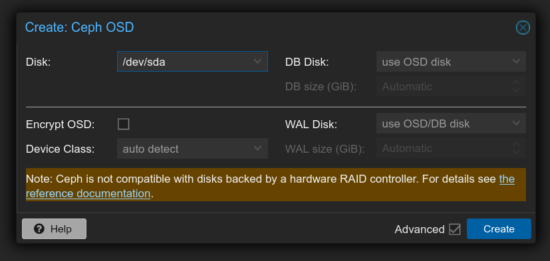

- Opération à réaliser sur chaque noeud, dans le menu Ceph, cliquer sur OSD puis sur « Create: OSD » :

- Sélectionner le premier disque puis cliquer sur « Create » :

- Répéter l’opération pour l’ensemble des disques :

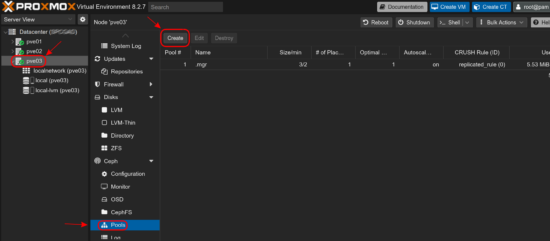

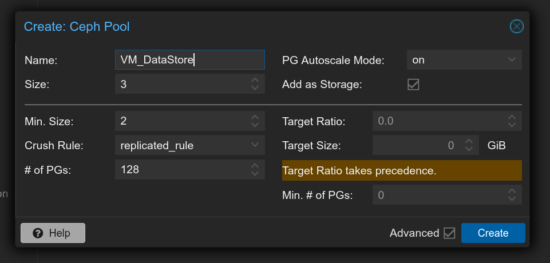

- Création du pool Ceph pour le stockage :

Mise en place de la HA pour les VMs

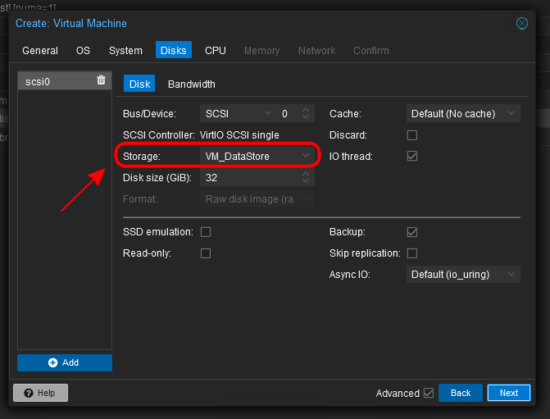

nb: Lors de la création d’une machine virtuelle, ne pas oublier de choisir le stockage correspondant au pool Ceph:

Encore à ce jour pour la gestion HA des machines virtuelles, j’utilise cette méthode -> https://memo-linux.com/proxmox-cluster-ha-repartition-de-charge-des-machines-virtuelles/

Comme tous les autres tutoriels qui traitent de la mise en place d’un cluster Proxmox avec Ceph pour le stockage, le processus semble relativement simple. Cependant, je constate que cette configuration n’est absolument pas exploitable en l’état pour gérer des VLAN, et c’est là que le bât blesse. Entre nous, quel intérêt y a-t-il à investir dans du matériel pour une telle configuration ? ;). Je te dis cela car depuis un bon moment, je tombe sur tes tutoriels, qui m’ont souvent appris beaucoup de choses. Un échange en retour me semble donc tout à fait approprié. Bonne continuation !

La gestion des VLANs est un autre sujet, ou ai-je mal compris la question ?

pour info, j’ai mis en prod ce type de cluster avec gestion multi-VLANs, soit avec interface réseau dédiée par VLAN (le plus simple mais faut autant de port que de VLAN) ou port trunck configuré au niveau du switch avec VLANs tagués. Dans le second cas, faut gérer les tags des VLANs au niveau de la VM.

Bonjour,

J’ai configuré HA avec un groupe de nœuds.

Je souhaite trouver un moyen d’ajouter automatiquement toutes les VM (actuelles et futures) aux ressources HA.

Avez-vous le bon processus à suivre ?

Bonjour Seb,

je ne connais pas de méthode automatique pour l’jout de VM dans la HA

je fais toujours de cette méthode : https://memo-linux.com/proxmox-cluster-ha-repartition-de-charge-des-machines-virtuelles/

Super tuto, j’ai pu le mettre en place chez moi sans soucis. Par contre, je comprend pas la différence entre ceph public et ceph cluster. Il n’y a que Proxmox qui accède à ceph, non ?

Merci Adrien :)

en gros :

le réseau ceph-cluster est le réseau dédié à la gestion interne du ceph (manager, gestion des OSDs, etc)

le réseau ceph-public est le réseau qui est « exposé » aux clients, qui ont besoin d’accéder au stockage. Ici les clients sont les noeuds proxmox.

Bukmekerlik va kazino Mostbet Uz Kirish mavzusiga oid kalit so‘zlar bilan to‘la, ammo haqiqiy kirish havolasi yoki login ma’lumotlarini oshkor qilmaydigan, xavfsiz va javobgar tahririy matn beraman.

mostbetuz com

Promo kodlar va bonuslar orqali tikish hajmi oshadi va sovrinlar ko‘proq bo‘ladi.