Un mémo sur comment ajouter un nœud Proxmox dans un cluster HA existant et l’ajout d’OSDs supplémentaires pour Ceph.

Pour l’exemple, le serveur ajouté au cluster possède 2 disques de 4To, qui seront ajoutés au pool correspondant à cette taille de disque.

nb : Attention, suivant la rapidité des disques, il peut y avoir une indisponibilité d’accès au VMs, qui sont stockées sur le pool où ont été ajoutés les OSDs dû à la duplication des données.

Ajout d’un nouveau nœud dans un cluster en production

Ce qui va suivre part du principe que le nouveau serveur Proxmox est installé, configuré et opérationnel.

- Renseigner le fichier

/etc/hostscomme les autres membres du cluster :

nano /etc/hosts

192.168.1.1 cluster-01 192.168.1.2 cluster-02 192.168.1.3 cluster-03 192.168.4.4 cluster-04

pvecm add cluster-01 -ring0_addr cluster-04 -force

- Via la commande

pvecm:

pvecm status

Quorum information

------------------

Date: Fri Mar 17 13:32:54 2017

Quorum provider: corosync_votequorum

Nodes: 4

Node ID: 0x00000004

Ring ID: 1/512

Quorate: Yes

Votequorum information

----------------------

Expected votes: 4

Highest expected: 4

Total votes: 4

Quorum: 3

Flags: Quorate

Membership information

----------------------

Nodeid Votes Name

0x00000001 1 192.168.1.1

0x00000002 1 192.168.1.2

0x00000003 1 192.168.1.3

0x00000004 1 192.168.1.4 (local)

Installer Ceph sur le nouveau nœud

- Installer Ceph :

https_proxy=http://IP_PROXY:PORT pveceph install -version jewel

Sur ce nœud, ne pas installer le moniteur car ils doivent être en nombre impaire.

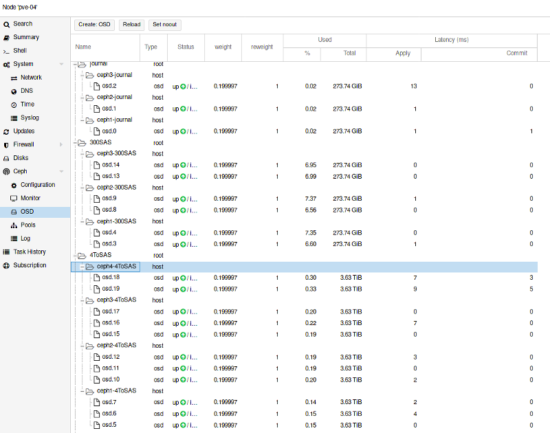

Création et ajout des OSDs sur le cluster Ceph existant

- Création des OSDs avec les disques de disponible :

pveceph createosd /dev/sd[X]

ceph osd crush add-bucket ceph4-4ToSAS host

ceph osd crush move ceph4-4ToSAS root=4ToSAS

ceph osd crush add osd.18 0.200 host=ceph4-4ToSAS

ceph osd crush add osd.19 0.200 host=ceph4-4ToSAS

- en mode cli :

ceph osd tree

ID WEIGHT TYPE NAME UP/DOWN REWEIGHT PRIMARY-AFFINITY -13 0.59999 root journal -4 0.20000 host ceph1-journal 0 0.20000 osd.0 up 1.00000 1.00000 -11 0.20000 host ceph2-journal 1 0.20000 osd.1 up 1.00000 1.00000 -12 0.20000 host ceph3-journal 2 0.20000 osd.2 up 1.00000 1.00000 -3 1.19998 root 300SAS -5 0.39999 host ceph1-300SAS 3 0.20000 osd.3 up 1.00000 1.00000 4 0.20000 osd.4 up 1.00000 1.00000 -6 0.39999 host ceph2-300SAS 8 0.20000 osd.8 up 1.00000 1.00000 9 0.20000 osd.9 up 1.00000 1.00000 -7 0.39999 host ceph3-300SAS 13 0.20000 osd.13 up 1.00000 1.00000 14 0.20000 osd.14 up 1.00000 1.00000 -2 2.19997 root 4ToSAS -8 0.59999 host ceph1-4ToSAS 5 0.20000 osd.5 up 1.00000 1.00000 6 0.20000 osd.6 up 1.00000 1.00000 7 0.20000 osd.7 up 1.00000 1.00000 -9 0.59999 host ceph2-4ToSAS 10 0.20000 osd.10 up 1.00000 1.00000 11 0.20000 osd.11 up 1.00000 1.00000 12 0.20000 osd.12 up 1.00000 1.00000 -10 0.59999 host ceph3-4ToSAS 15 0.20000 osd.15 up 1.00000 1.00000 16 0.20000 osd.16 up 1.00000 1.00000 17 0.20000 osd.17 up 1.00000 1.00000 -14 0.39999 host ceph4-4ToSAS 19 0.20000 osd.19 up 1.00000 1.00000 18 0.20000 osd.18 up 1.00000 1.00000